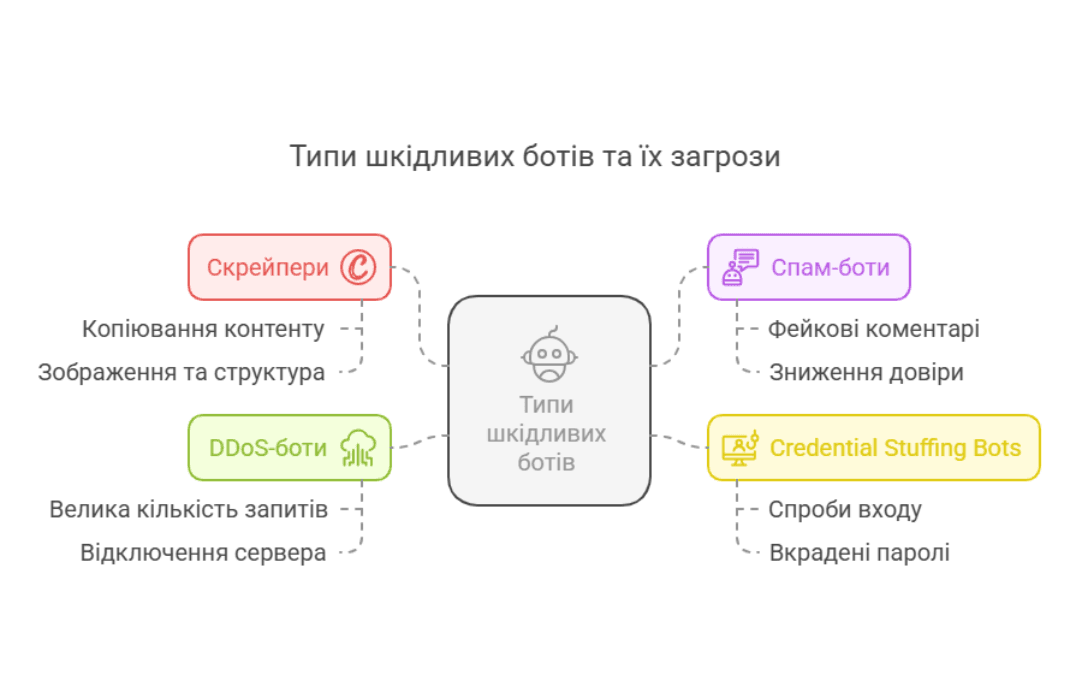

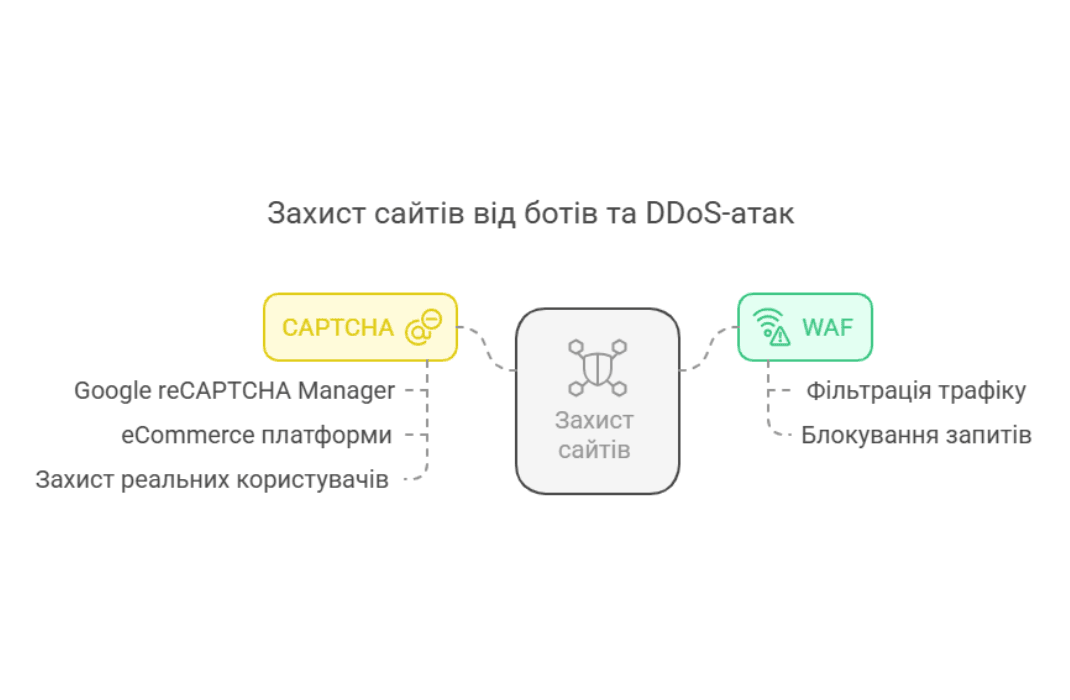

Сьогодні захист сайту від ботів стає не просто рекомендованою практикою, а необхідністю. Хоча деякі автоматизовані системи виконують корисні функції, наприклад, індексують контент для пошукових систем або забезпечують моніторинг доступності сайту, значна частина бот-трафіку є шкідливою. Вона включає в себе спроби викрадення даних, завантаження серверів до критичного рівня, розсилку спаму через форми на сайті, а також автоматизовані атаки з метою отримання несанкціонованого доступу.

Власники вебсайтів часто не можуть самостійно визначити, які запити надходять від корисних ботів (наприклад, Googlebot) і які є частиною шкідливих атак. Без належного моніторингу та заходів безпеки компанії можуть зіткнутися з серйозними наслідками: від зниження продуктивності сайту та падіння позицій у пошуковій видачі до втрати прибутку та зниження довіри користувачів.

Ця стаття допоможе розібратися, як шахрайський бот-трафік впливає на роботу сайту, як виявити незвичайні патерни поведінки користувачів та які методи дозволять запобігти атакам.